Die Arbeitsumgebung im elektroakustischen Studio unserer Tage ist vor allem durch Computer und Bildschirme bestimmt. Die kompositorische Arbeit mit Klang ist wesentlich mehr, als zu Zeiten analoger Maschinen, durch visuelle Kontrolle geprägt.

Die zu bearbeitenden Klänge werden auf den Bildschirmen durch grafische Repräsentationen abgebildet. Viele der Klangbearbeitungsprogramme erwarten die Eingabe von Kontrollwerten durch Zahlen oder Schieberegler bzw. Drehknöpfe, die meist mit der Maus eingestellt werden.

Durch diese technischen Vorgaben kommt es meines Erachtens zu einer sehr isolierten, parameterorientierten Kontrolle, die eine simultanes Einflussnehmen auf mehrere Klangcharakteristiken nur schwer ermöglicht.

Bei Verwendung zusätzlicher, externer Steuergeräte (Midifader, graphische Tabletts, analoge Sensoren) können Kontrollinstrumente konfiguriert werden, die wieder einen gestischeren Zugriff auf die Klanggestaltung ermöglichen.

Z.B. kann man die verschiedenen Dimensionen des Stiftes eines graphischen Tabletts unterschiedlichen musikalischen Parametern zuordnen und durch eine einzige Stiftbewegung eine komplexe Kontrolle vieler Klangbearbeitungsparameter erreichen.

Das Wacom-Tablett ist ein solches Eingabegerät, ursprünglich für Graphiker und Designer entwickelt. Der Stift kann gleichzeitig fünf kontinuierliche Kontrollparameter erzeugen : x-position und y-position auf dem Tablett, Neigung des Stiftes auf der x- und y-Achse und Druck des Stiftes auf das Tablett.

Wenn jeder dieser fünf Parameter direkt mit einem musikalischen Parameter verbunden wird, erreichen wir schon eine komplexere Kontrolle, als es mit fünf Reglern auf einem Midi-Mischer zu realisieren wäre. Da während der Bewegungsgeste des Stiftes verschiedene der fünf Parameter miteinander reagieren, muss man experimentieren, welche Verknüpfung der Stiftparameter mit bestimmten musikalischen Parametern sinnvoll ist. Diese Verbindung von Steuerwerten mit Bearbeitungsparametern (engl.: mapping) ist der schwierigste Schritt beim Entwickeln eines Kontrollinstruments, das, ähnlich wie ein traditionelles Musikinstrument, direkt auf die Gestik des Spielers reagieren soll. Die Entsprechungen von den meist linearen physikalischen Parametern (Ort oder Neigung des Stiftes) mit ihren musikalischen Parametern verläuft dabei meist nicht linear. D.h., es müssen durch experimentieren geeignete “Übersetzungen” der gestischen Bewegungen in sinnvolle musikalische Wertebereiche gefunden werden, die sowohl der Ergonomie der Bewegung, als auch der gewünschten Klangbearbeitung genügen.

Ähnlich wie mit solche einem graphischen Tablett können auch andere Steuersignale von analogen Sensoren genutzt werden. Zum Beispiel konnte ich mit Druck- und Flexionssensoren arbeiten. Erstere ändern ihren Widerstand bei zunehmendem Druck, letztere sind längliche Streifen, die ca. die Länge eines Fingers haben. Heftet man diese auf einen Handschuh, kann man fünf Kontrolldatenströme erzeugen, deren Werte davon abhängen, wie weit die einzelnen Finger gebeugt sind.

Hier kommen wir an ein sehr gut nachzuvollziehendes Element der Instrumentenkonstruktion. Da niemand einen einzelnen Finger völlig unabhängig von den anderen bewegen kann, entstehen Abhängigkeiten untereinander, die bei der Auswertung der Parameter beachtet, oder besser noch ausgenutzt werden können.

Eine menschliche Geste ist ein mehrdimensionales Geschehen, das sich in eine mehrdimensionale Steuerung übersetzen lässt und somit einen gestischen “Zugriff” auf die Klangbearbeitung ermöglicht.

Ein weiteres Experimentierfeld ist meine Suche nach interaktiven Klangbearbeitungen, die nicht als statische Effekte funktionieren. Dies bedeutet, dass man nicht eine bestimmte Klangbearbeitung mit gewählten statischen Parametern ausführt, sondern währen der Transformation die Entwicklung des zu bearbeitenden Ausgangsklanges analysiert und aus dessen Morphologie Steuerparameter ableitet, die direkt die Bearbeitung beeinflussen.

Programmierumgebungen wie Max/MSP oder SuperCollider (beide im Moment ausschließlich auf Macintosh-Computern erhältlich) geben den experimentierenden Musikern ein Werkzeug in die Hand, eigene Beziehungssysteme zu schaffen, die durch den allgemeinen Soft- und Hardwaremarkt nicht abgedeckt werden.

Im Laufe der letzten zwei Jahre konnte ich in der Umgebung Max/MSP ein solches Studioinstrument entwickeln, dessen Aspekte ich im Folgenden kurz beschreiben möchte.

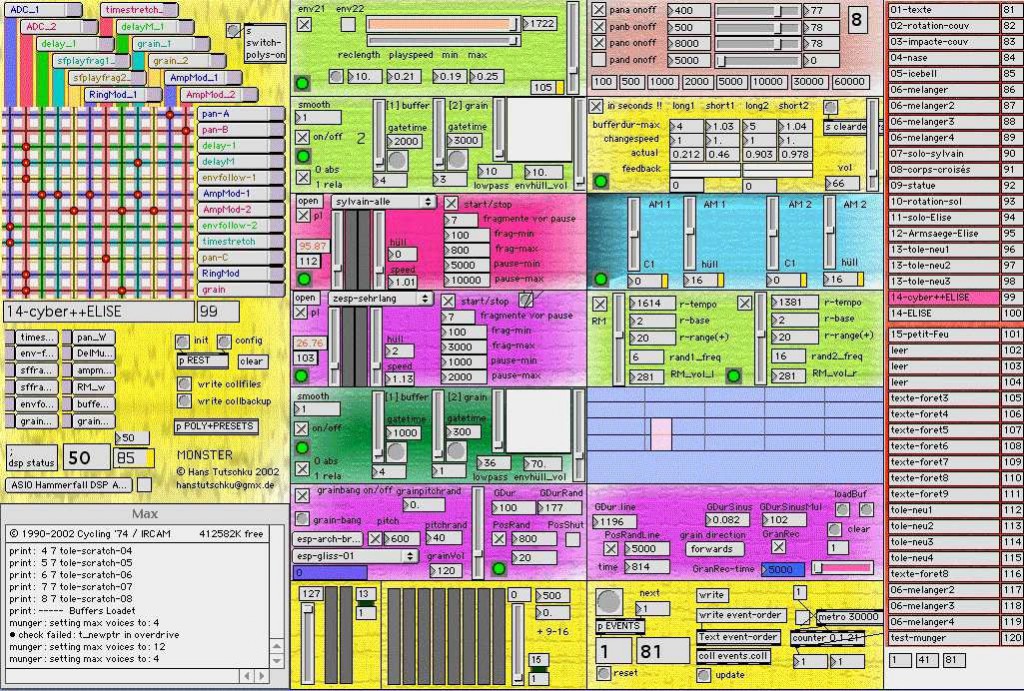

Das “Monster” ist eine modulare Klangbearbeitungsumgebung, die sich sowohl für den live-elektronischen Einsatz, zur Improvisation als auch als Studioinstrument verwenden lässt.

Es stellt eine Sammlung von Transformationsmodulen dar. Jedes Einzelmodul hat Signalein- und ausgänge, die untereinander nicht vorverkabelt sind. Alle Verbindungen werden durch eine Matrix vorgenommen. Dies ermöglicht die größte Flexibilität, sowohl in der parallelen als auch sequenziellen Signalführung durch die Module.

Lediglich die gerade verwendeten Module werden eingeschaltet, um effizient mit den Ressourcen des Prozessors umzugehen. Die Anzahl der gleichzeitig verwendbaren Module hängt von ihrer jeweiligen Komplexität und der Gesamtrechenleistung des Computers ab.

Die Kontrollwerte eines spezifischen Moduls werden in kleinen Fenstern dargestellt, von denen bis zu 12 im zentralen Bereich des Bildschirms dargestellt werden können.

Alle Konfigurationseinstellungen und die aktuellen Steuerdaten der Module können in Presets auf der rechten Seite abgespeichert werden. So ist es in der Konzertsituation einfach, auf vorgewählte Kombinationen zurückzugreifen.

Links oben ist die Matrix deren Spalten die Quellen und deren Linien die Ziele darstellen. Für jede Linie und Spalte gibt es ein Menü zur Auswahl der jeweiligen Quelle bzw. des gewünschten Ziels. Wird ein roter Punkt in der Matrix gesetzt, entsteht an dieser Stelle eine Signalverbindung zwischen der Quelle und dem Ziel.

Rechts davon sieht man 12 Kontrollfenster, die von der jeweiligen Modulauswahl abhängen. An der rechten Seite befinden sich die Presets, in denen alle Einstellungen abgespeichert werden.

Da in diesem System die Informationen als Signale versendet werden, ist es sehr einfach, zum Beispiel den Lautstärkeverlauf eines angeschlossenen Mikrophons an die Tonhöhenentwicklung eines abzuspielenden Soundfiles zu koppeln.

Die oben erwähnte Analyse bestimmter morphologischer Eigenschaften eines Klanges (Entwicklung im Klangspektrum, Tonhöhe, Lautstärke etc.) kann somit in Echtzeit auf Transformationsparameter geschaltet werden und das Ergebnis ist eine dynamische, sich verändernde Klangverarbeitung, die wesentlich gestischer ist, als eine statische.

Die Kurse an der TU-Berlin werden sowohl einen Überblick über technische Lösungen und Möglichkeiten geben, als auch realisierte Kompositionen analysieren, die sich dieser Technologien bedienen.